Материалы по тегу: sambanova systems

|

29.02.2024 [13:01], Владимир Мироненко

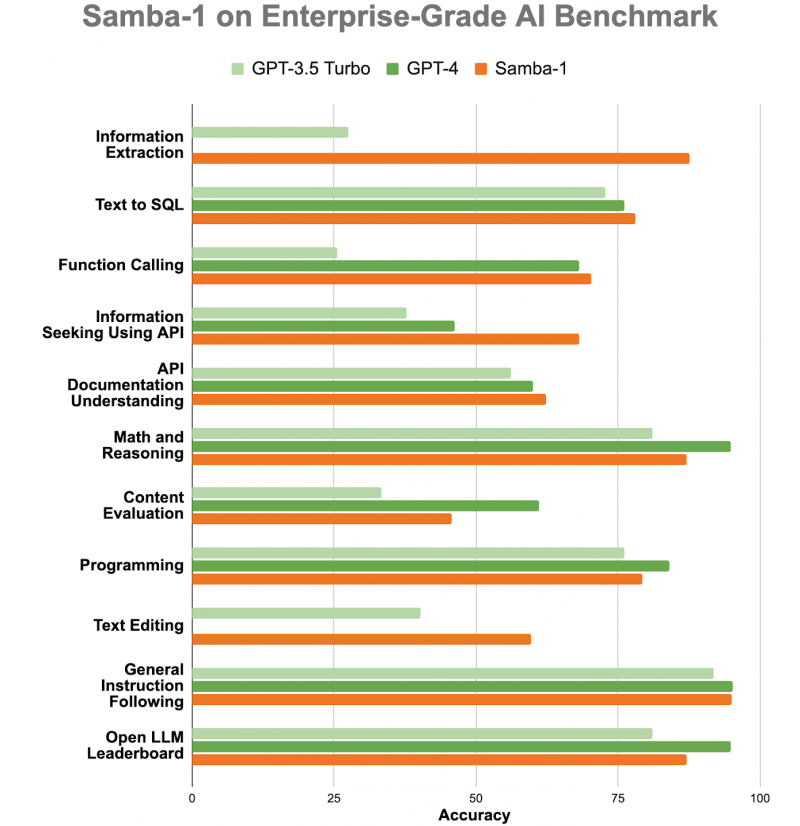

ИИ-консилиум: корпоративная LLM Samba-1 c 1 трлн параметров объединила более 50 открытых моделейСтартап SambaNova Systems представил Samba-1, модель генеративного ИИ с 1 трлн параметров, предназначенную для использования предприятиями. SambaNova описывает новую модель как «объединение экспертных архитектур» (Composition of Experts, CoE), которое включает более 50 открытых моделей генеративного ИИ высочайшего качества, в том числе Llama2 7B/13B/70B, Mistral 7B, DeepSeek Coder 1.3B/6.7B/33B, Falcon 40B, DePlot, CLIP, Llava. В частности, Llama 2 может генерировать текст, создавать программный код и решать математические задачи. Есть и более специализированные LLM, такие как DePlot от Google, которая может вводить информацию из диаграмм и других визуализаций данных в электронную таблицу. Samba-1 уже используется клиентами и партнёрами SambaNova, включая Accenture и NetApp. SambaNova позиционирует Samba-1 как первую модель с 1 трлн параметров для предприятий с регулируемой деятельностью, которая является приватной, безопасной и на порядок более эффективной, чем любая другая модель такого размера. Заказчик может установить контроль доступа к данным для отдельных пользователей. Желающие могут ознакомиться с работой модели. По словам главы SambaNova, Samba-1 оптимизирована для работы с чипом SN40L, выпущенным стартапом прошлой осенью. «Samba-1 способна конкурировать с GPT-4, но она лучше подходит для предприятий, поскольку её можно развернуть как локально, так и в частном облаке, чтобы клиенты могли точно настроить модель с использованием своих личных данных, не отдавая их в открытый доступ», — добавил он. SambaNova утверждает, что инференс этой модели обходится в десять раз дешевле, чем для конкурирующих LLM. Получив запрос, Samba-1 решает, какая из её внутренних моделей лучше всего приспособлена для его обработки, и поручает ей сгенерировать ответ. То есть активируется только одна из относительно небольших моделей, тогда как традиционные монолитные LLM требуют активации целиком. Стартап SambaNova привлёк около $1 млрд инвестиций от ряда компаний, включая Intel Capital и GV (инвестиционное подразделение Alphabet Inc). По итогам раунда финансирования в начале 2021 года рыночная стоимость стартапа оценивается в более чем $5 млрд.

24.11.2023 [17:14], Сергей Карасёв

Лос-Аламосская национальная лаборатория внедрит обновлённые ИИ-системы SambaNovaЛос-Аламосская национальная лаборатория (LANL) Министерства энергетики США (DOE) заключила соглашение о сотрудничестве со стартапом SambaNova Systems, который специализируется на разработке ИИ-решений. Финансовые условия договора не раскрываются, но ранее стартап уже поставлял LANL свои решения. В рамках партнёрства LANL расширит применение программно-аппаратных комплексов SambaNova DataScale. Речь идёт о системе DataScale SN30, содержащей восемь ускорителей собственной разработки Cardinal SN30, суммарно имеющих 5 Гбайт SRAM и 8 Тбайт DRAM. Конфигурация комплекса может включать от одного до трёх узлов SN30. Кроме того, LANL внедрит решение SambaNova Suite для генеративного ИИ. Эта платформа предоставляет различные ИИ-модели, оптимизированные для корпоративных и государственных организаций. Они могут быть развёрнуты локально или в облаке с возможностью адаптации к собственному набору данных заказчика.

Источник изображения: SambaNova Новое многолетнее соглашение между LANL и SambaNova является расширением действующего партнёрства между сторонами. Лаборатория будет использовать технологии SambaNova для решения широкого спектра задач, связанных с ИИ и большими языковыми моделями (LLM), в том числе в интересах национальной безопасности. Отмечается, что платформа SambaNova Suite предлагает быстрый и эффективный способ развёртывания генеративного ИИ для реализации самых сложных проектов.

20.09.2023 [20:05], Алексей Степин

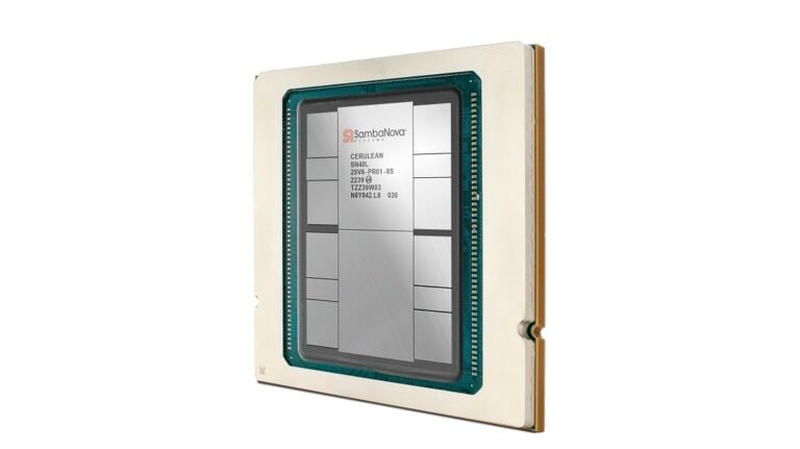

SambaNova представила ИИ-ускоритель SN40L с памятью HBM3, который в разы быстрее GPUБум больших языковых моделей (LLM) неизбежно порождает появление на рынке нового специализированного класса процессоров и ускорителей — и нередко такие решения оказываются эффективнее традиционного подхода с применением GPU. Компания SambaNova Systems, разработчик таких ускорителей и систем на их основе, представила новое, третье поколение ИИ-процессоров под названием SN40L. Осенью 2022 года компания представила чип SN30 на базе уникальной тайловой архитектуры с программным управлением, уже тогда вполне осознавая тенденцию к увеличению объёмов данных в нейросетях: чип получил 640 Мбайт SRAM-кеша и комплектовался оперативной памятью объёмом 1 Тбайт.

Источник изображений здесь и далее: SambaNova (via EE Times) Эта наработка легла и в основу новейшего SN40L. Благодаря переходу от 7-нм техпроцесса TSMC к более совершенному 5-нм разработчикам удалось нарастить количество ядер до 1040, но их архитектура осталась прежней. Впрочем, с учётом реконфигурируемости недостатком это не является. Чип SN40L состоит из двух больших чиплетов, на которые приходится 520 Мбайт SRAM-кеша, 1,5 Тбайт DDR5 DRAM, а также 64 Гбайт высокоскоростной HBM3. Последняя была добавлена в SN40L в качестве буфера между сверхбыстрой SRAM и относительно медленной DDR. Это должно улучшить показатели чипа при работе в режиме LLM-инференса. Для эффективного использования HBM3 программный стек SambaNova был соответствующим образом доработан.

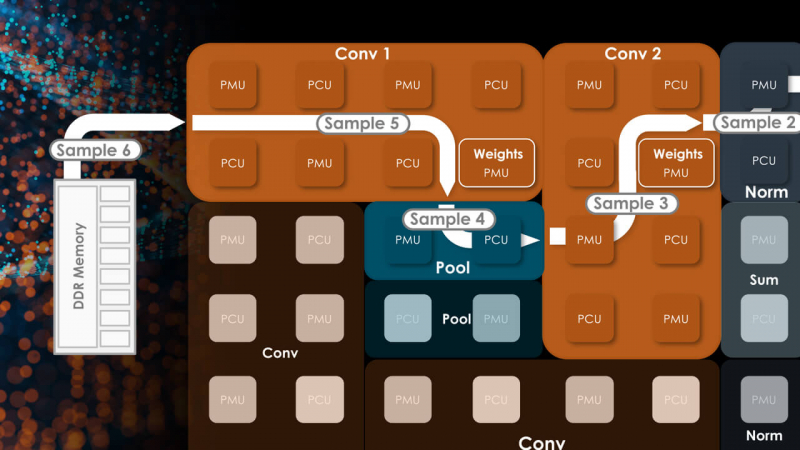

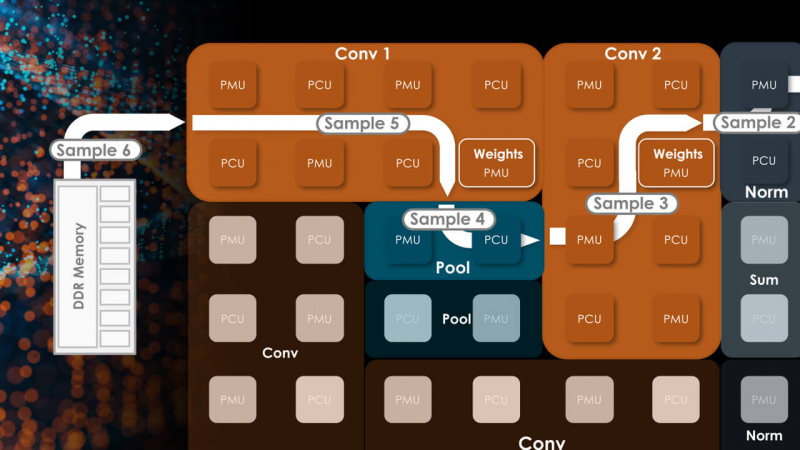

Тайловая архитектура SambaNova состоит из вычислительных тайлов PCU, SRAM-тайлов PMU, управляющей логики и меш-интерконнекта По сведениям SambaNova, восьмипроцессорная система на базе SN40L сможет запускать и обслуживать ИИ-модель поистине титанических «габаритов» — с 5 трлн параметров и глубиной запроса более 256к. В описываемой модели речь идёт о наборе экспертных моделей с LLM Llama-2 в качестве своеобразного дирижёра этого оркестра. Архитектура с традиционными GPU потребовала бы для запуска этой же модели 24 сервера с 8 ускорителями каждый; впрочем, модель ускорителей не уточняется. Как и прежде, сторонним клиентам чипы SN40L и отдельные вычислительные узлы на их основе поставляться не будут. Компания продолжит использовать модель Dataflow-as-a-Service (DaaS) — расширяемую платформу ИИ-сервисов по подписке, включающей в себя услуги по установке оборудования, вводу его в строй и управлению в рамках сервиса. Однако SN40L появится в рамках этой услуги позднее, а дебютирует он в составе облачной службы SambaNova Suite.

16.11.2022 [15:17], Сергей Карасёв

SambaNova поставит Аргоннской национальной лаборатории ИИ-систему DataScale нового поколенияСтартап SambaNova Systems сообщил о расширении сотрудничества с Аргоннской национальной лабораторией Министерства энергетики США. В рамках многолетнего соглашения компания установит вычислительную систему DataScale нового поколения. Комплекс обеспечит ускорение выполнения различных ИИ-задач, включая обработку изображений и масштабных языковых моделей. DataScale — полностью интегрированная программно-аппаратная платформа, которая позволяет компаниям и организациям переосмыслить свой подход к ИИ. Система второго поколения DataScale SN30 содержит ускоритель собственной разработки Cardinal SN30, особенностью которого является возможность реконфигурации. Решение содержит 640 Мбайт кеша SRAM и 1 Тбайт DRAM.

Источник изображения: Аргоннская национальная лаборатория В рамках соглашения с Аргоннской национальной лабораторией комплекс DataScale будет доступен научному сообществу на базе площадки ALCF AI Testbed. Она помогает исследователям во внедрении ИИ и алгоритмов глубокого обучения в науке. Специалисты лаборатории применяли комплекс SambaNova предыдущего поколения для широкого спектра исследовательских проектов. Это, в частности, разработка суррогатных моделей для повышения точности прогнозирования погоды, ускорение моделирования гидродинамики для исследований в области двигателестроения и обработка изображений высокого разрешения для повышения эффективности экспериментальных открытий. Кроме того, система используется для проектов в области периферийных вычислений, нейтринной физики и прогнозирования злокачественных образований.

16.09.2022 [22:58], Алексей Степин

SambaNova Systems представила второе поколение ИИ-систем DataScale — SN30 с 5 Гбайт SRAM и 8 Тбайт DRAMСтартап SambaNova, решивший бросить вызов NVIDIA, представил второе поколение систем машинного обучения — DataScale SN30. В основе лежит собственная разработка компании, ускоритель Cardinal SN30, для обозначения которого SambaNova использует термин Reconfigurable Data Flow Unit (RDU). На новинку уже обратили внимание такие организации, как Аргоннская национальная лаборатория (ANL) и Ливерморская национальная лаборатория им. Э. Лоуренса (LLNL). Cardinal SN30 состоит из 86 млрд транзисторов и производится с использованием 7-нм техпроцесса TSMC. Главной его особенностью является возможность реконфигурации: создатели уподобляют этот процессор сложным FPGA. Последним он уступает в степени гибкости, поскольку не может менять конфигурацию на уровне отдельных логических вентилей, зато выигрывает в скорости перепрограммирования и уровне энергопотребления. За это отвечает фирменный программный стек.

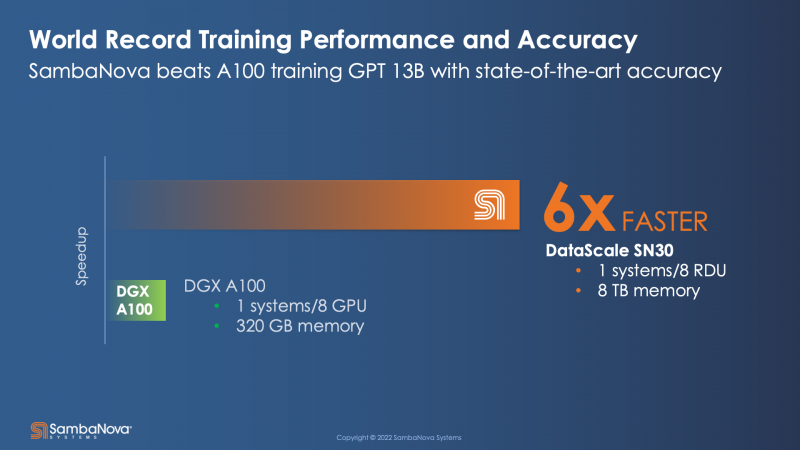

Источник: HPCwire Большой упор SambaNova сделала на объёме локальной памяти, поскольку современные модели машинного обучения имеют тенденцию к гигантомании. Только SRAM-кеша у Cardinal SN30 640 Мбайт, а объём DRAM составляет 1 Тбайт. По своим параметрам SN30 вдвое превосходит чип первого поколения, SN10, но имеет такую же тайловую архитектуру с программным управлением. Каждый тайл содержит блоки PCU, отвечающие за вычисления, блоки PMU, содержащие SRAM и обслуживающую логику, а также mesh-интерконнект, обслуживаемый блоками коммутаторов. Такой подход к построению процессора весьма напоминает Tesla D1, у которых вычислительные блоки похожим образом чередуются с блоками быстрой SRAM-памяти. Отдельно ускорители компания не поставляет, минимальная конфигурация готовой 42U-системы DataScale включает в себя 8 чипов SN30. Комплектация может включать в себя от одного до трёх узлов SN30. Воспользоваться возможностями DataScale можно и в виде услуги, поскольку новинка легко интегрируется в облачные среды и полностью поддерживает платформу Kubernetes. Полный список провайдеров ещё уточняется, на сегодняшний момент партнерами SambaNova являются Aicadium, Cirrascale и ORock. Высокая производительность в режиме bfloat16 является главным достоинством новинки — по словам вице-президента SambaNova, каждый чип развивает 688 Тфлопс. Это более чем вдвое выше показателя A100, составляющего 312 Тфлопс. По словам компании, DataScale SN30 вшестеро производительнее NVIDIA DGX A100 (40 Гбайт) и эффективнее всего проявляет себя при обучении сверхбольших моделей вроде GPT-3 с её 13 млрд параметров. Однако нельзя не отметить, что, во-первых, сравнение идёт со старым продуктом NVIDIA, которая вот-вот представит DGX H100, а во-вторых, SambaNova не упоминает в явном виде энергопотребление одного узла SN30. |

|